Alles im Griff

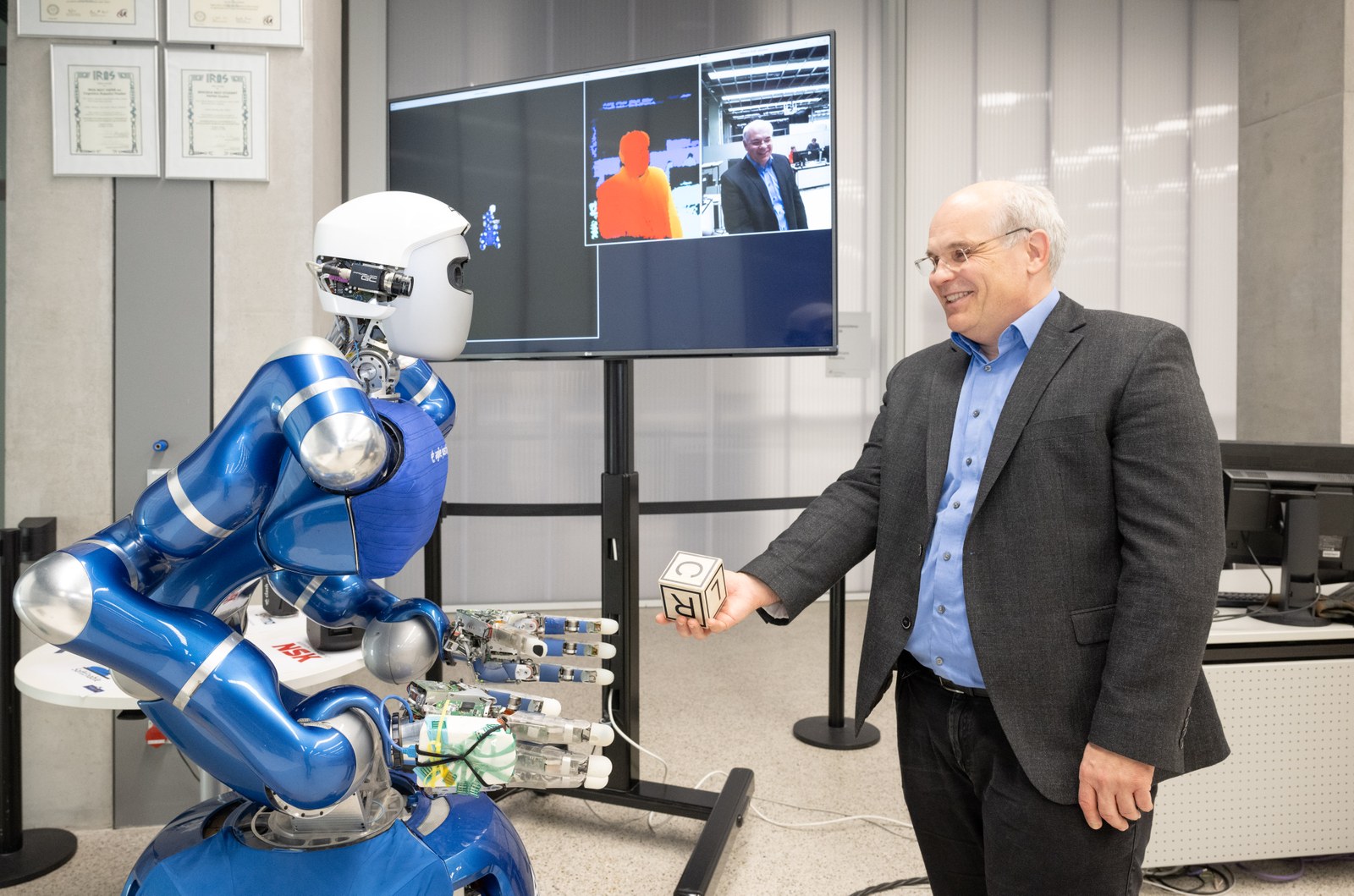

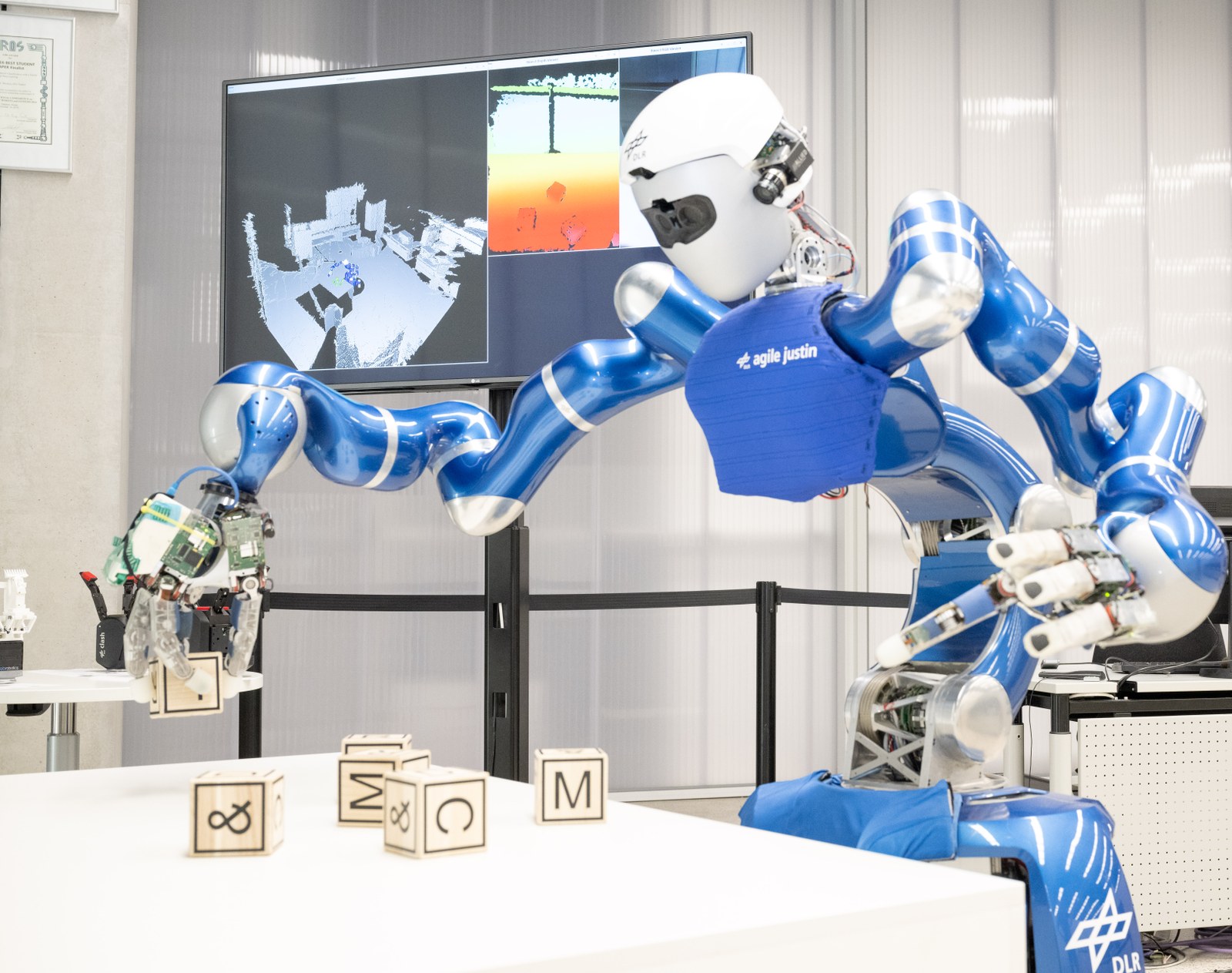

Justin sortiert Holzwürfel auf einem Tisch. Unermüdlich. Er dreht sie geschickt zwischen den Fingern, bringt sie in die gewünschten Positionen, keiner fällt ihm aus der Hand. Justin kann die Würfel auch stapeln. Die Buchstaben auf den Würfeln bilden die Kombination DLR RMC. Das steht für Deutsches Zentrum für Luft- und Raumfahrt, Robotik und Mechatronik Zentrum – Justins Zuhause. Man möchte ihn loben für seine Leistung, denn sie ist weltklasse. Aber wäre etwas wie „Das hast du toll gemacht!“ hier passend? Justin ist ein humanoider Roboter. In diesen Tagen wird er 18 Jahre alt, also nach menschlichen Maßstäben volljährig. Aus Robotiksicht entspricht das Generationen.

Doch sein Alter ist kein Hindernis, ganz im Gegenteil: Was der Roboter in den letzten Monaten durch künstliche Intelligenz (KI) dazugelernt hat, bedeutet einen Durchbruch in der Forschung. Weltweit zählt Justin zu den komplexesten, am weitesten entwickelten Robotiksystemen. Er ist Teil einer ganzen „Familie“ von humanoiden DLR-Robotern, die ähnlich schlau sind. Ihre Zukunft liegt im Weltraum, in der Produktion und in der Pflege.

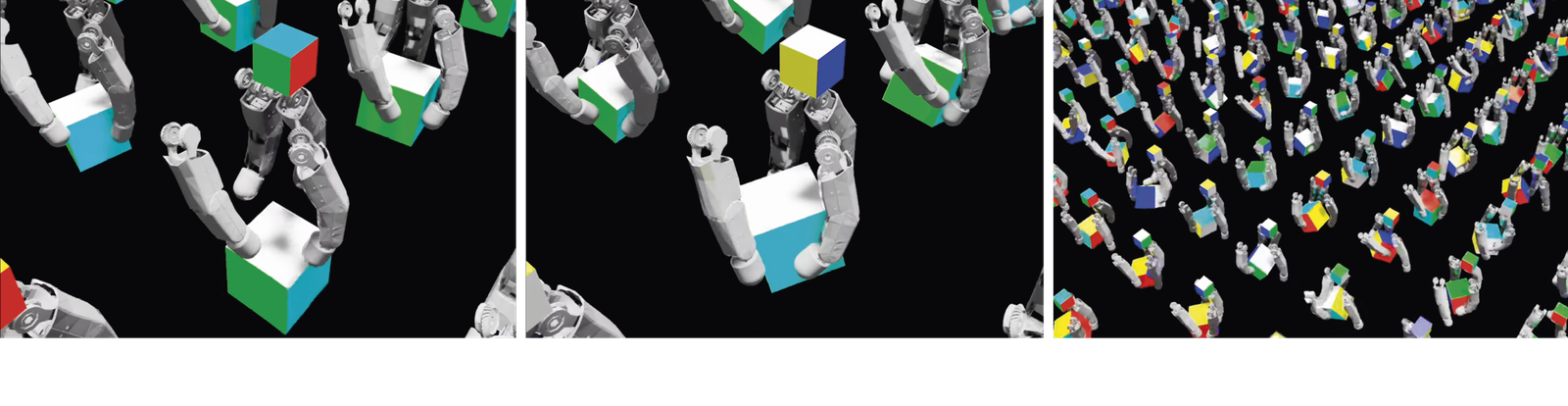

Um es vorwegzunehmen: Ja, Justin wird gelobt, sogar tausendfach. So hat er zum Beispiel gelernt, den Würfel in den Fingern mit der nach unten offenen Hand zu drehen. Bei jedem Erfolg bekam er Pluspunkte und auf seine Art ist er ehrgeizig. „Er versucht, über die Zeit eine hohe Gesamtbelohnung zu erreichen. Runterfallen lassen gibt ein ziemlich großes Minus“, erklärt Prof. Berthold Bäuml vom DLR-Institut für Robotik und Mechatronik. Justin steht beim Lernen nicht an einem Tisch und dreht Gegenstände. So üben nur Menschen spielerisch die Koordination von Augen und Händen. Das Zusammenspiel von Muskeln und Gelenken läuft dann meistens wie von selbst. Aber es ist dennoch hochkomplex und für Roboter bisher nicht zu schaffen. Das funktioniert erst seit Kurzem mit lernender KI. Justin lernt die Bewegungen in einer Simulation von bis zu 4.000 Händen gleichzeitig. Er sammelt dabei am Ende sehr viele Pluspunkte. „Das Training dauert fünf Stunden, dann ist er bei fast 100 Prozent“, sagt Berthold Bäuml. „Am Anfang ist die Bewegung der Finger völlig zufällig: Der Würfel fällt oft herunter. Aber nach einer Stunde Training macht Justin schon 70 Prozent der Aufgaben richtig.“ Das Prinzip heißt Deep Reinforcement Learning, bestärkendes Lernen. Dazu reicht eine einzige Standard-Grafikkarte, die Rechenleistung wird über eine Cloud bereitgestellt.

Was sieht ein Mensch? Was sieht ein humanoider Roboter?

Agile Justin, so lautet sein voller Name, ist 1,91 Meter groß, sein Oberkörper wiegt 45 Kilogramm, sein Untersatz auf Rädern 150 Kilogramm. Das Gesamtsystem hat 53 bewegliche Gelenke mit ebenso vielen Motoren. Er ist mit sensorischen und motorischen Fähigkeiten ausgestattet, die denen des Menschen nahekommen. Wer ihn anschaut, sieht eine runde Kopfform mit einer silbrig-weißen Hülle, die „Augenpartie“ für die Farbkameras ist schwarz ausgespart, gelegentlich flackert ein rotes Licht. Dort, wo anatomisch Ohren vermutet werden, stecken zwei Stereokameras. Es gehe nicht darum, einen Menschen exakt nachzubauen, sagen Robotik-Fachleute. Die Form ergibt sich durch die Aufgaben und weil der Roboter an eine menschengemachte Umgebung angepasst wird. Und natürlich ergibt es Sinn, die Kameras oben auf einem beweglichen Kopf zu haben.

Was sieht Justin eigentlich? Berthold Bäuml schaltet einen Monitor an. Eine Darstellung zeigt die Umgebung genau so, wie Menschen sie sehen. Eine andere zeigt die gleichen Konturen, aber mit einem Farbverlauf. Was nah an Justins Kopfkamera ist, erscheint leuchtend rot. Dann geht es über Orange, Gelb und Grün zu Blau. Justin kann sich sofort ein genaues dreidimensionales Modell von allem machen, was in seinem Blickfeld ist. „Das funktioniert wie bei Menschen, rein auf den eigenen Sensoren basierend“, betont Berthold Bäuml.

Der humanoide Roboter handhabt nicht nur Würfel, sondern auch beliebige Gegenstände, die leichter sind als 15 Kilogramm. Wie kann das funktionieren, wenn Justin nur die Vorderseite sieht, die Finger sich aber auch um die Rückseite schließen müssen? Hier ist den Forschenden im DLR ein weiterer Durchbruch mit KI gelungen: Justin versteht jetzt die gesamte Form und passt seine Aktionen an. Eine Plastikflasche, eine Vase, ein Schuh, ein Kuscheltier – nur eine Ansammlung von Punkten, aber Justin berechnet in Sekundenbruchteilen die Ausmaße sowie die beste Strategie und greift zu. Mit 50.000 Beispielen und tagelangem Training in Simulationen hat er ein Verständnis für alle dreidimensionalen Formen entwickelt.

… und dann bringt Justin sich selbst einen Würfeltrick bei

Beim Würfeldrehen fühlt Justin durch Kraftsensoren, wie Dinge in seiner Hand liegen. Er schätzt die Position über die Stellung der Finger und die gefühlte Kraft. Klar – auch das lernt Justin in einer Simulation. Und dann kam der Moment, in dem die Robotik-Expertinnen und -Experten im DLR kurz sprachlos waren: Justin hat einen seiner Finger zwischenzeitlich stützend unter den Würfel geschoben. „Da hat er sich selbst einen Trick beigebracht“, sagt Berthold Bäuml. Justins Strategie lautete ungefähr so: Den Würfel nicht fallen lassen und immer die richtige Lage kennen – das geht besser, wenn der Würfel nicht verrutscht, deswegen kurz untergreifen, um die Lage wieder abzuschätzen. Die vier Finger an seiner Roboterhand arbeiten also dank der lernenden KI fein koordiniert zusammen.

Video: Berthold Bäuml erklärt die Fähigkeiten von Roboter Justin

Für die Wiedergabe dieses Videos auf Quickchannel.com ist Ihre Zustimmung zur Speicherung von Daten ('Cookies') erforderlich. Unter Datenschutz-Einstellungen können Sie Ihre Wahl einsehen und verändern.

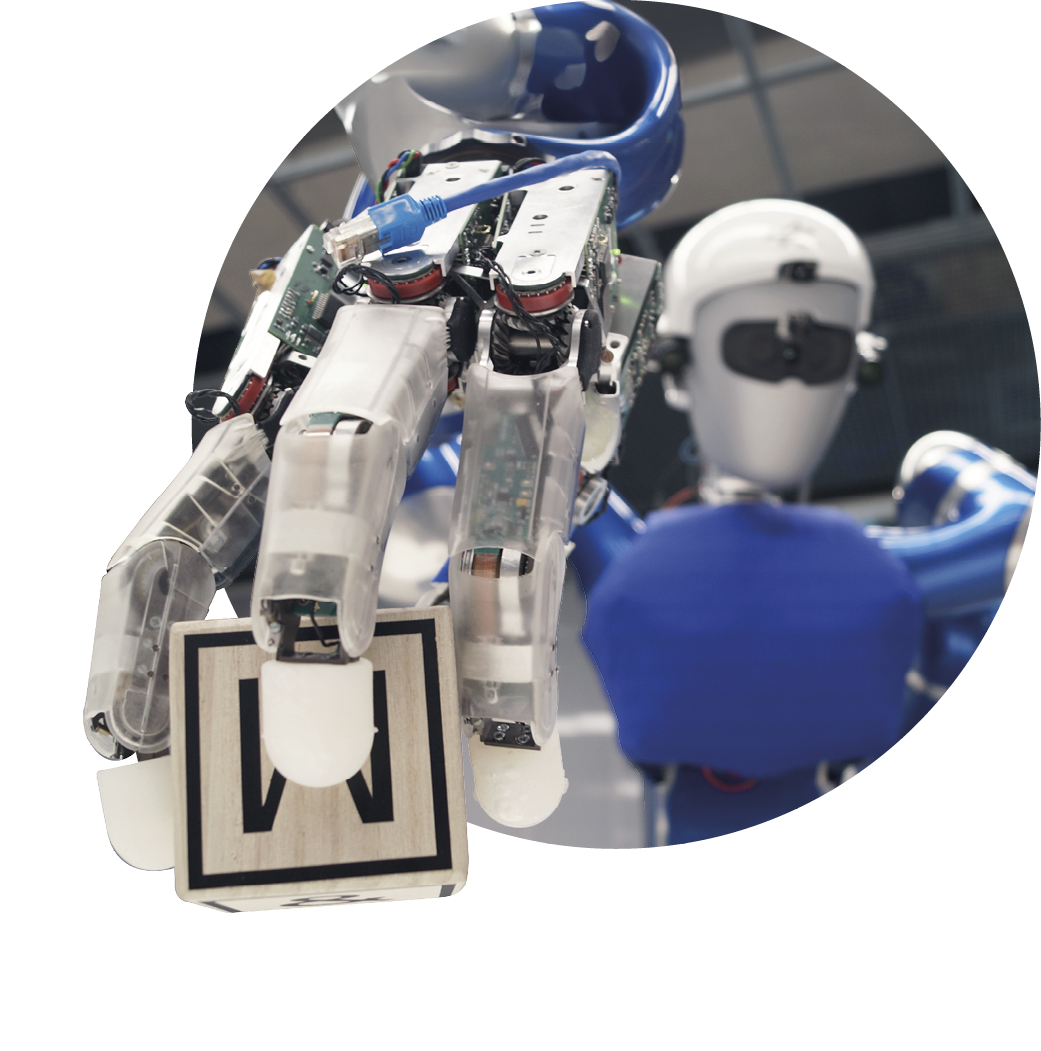

Fünf Finger? Vier reichen

Vier Finger? „Fünf Finger beim Menschen sind schon genial von der Natur gemacht. Aber meistens braucht man nur vier“, sagt Prof. Gerhard Hirzinger. „Mit einem fünften kann man kaum mehr machen, aber der Griff wird stabiler.“ Gerhard Hirzinger war von 1992 bis 2012 Leiter des DLR-Instituts für Robotik und Mechatronik und Vorgänger von Prof. Alin Albu-Schäffer. Justins Hände sind etwas größer als menschliche Hände, weil sie alle notwendigen Sensoren und Motoren enthalten und schnell ausgetauscht werden können. Beim Menschen stecken dagegen viele Muskeln für die Hände in den Unterarmen.

Systeme wie Justin bauen, betreiben und über Jahre entscheidend weiterentwickeln – das kann keine Universität. Das schafft nur eine Großforschungseinrichtung wie das DLR, in der Teams über Jahre zusammengehalten werden.

Bei seinem ersten öffentlichen Termin im Jahr 2006 war Justin noch ein Torso ohne rollenden Untersatz. Er reagierte feinfühlig auf Berührungen mit der Umgebung und wich zurück, was eine direkte Interaktion zwischen Mensch und Roboter ermöglichte. Bis dahin mussten Roboter hinter Sicherheitszäunen bleiben. Justin dagegen konnte Bälle werfen und fangen, Getränke einschenken und Hände schütteln. „Systeme wie Justin bauen, betreiben und über Jahre entscheidend weiterentwickeln – das kann keine Universität. Das schafft nur eine Großforschungseinrichtung wie das DLR, in der Teams über Jahre zusammengehalten werden“, ist Gerhard Hirzinger überzeugt. Gibt es Probleme, wissenschaftlichen Nachwuchs für die Robotik zu begeistern? „Eigentlich nicht.“

Feinfühlige Maschinen

Interview mit Prof. Alin Albu-Schäffer. Er ist seit 2012 Direktor des Instituts für Robotik und Mechatronik in Oberpfaffenhofen.

Was ist das Faszinierende an der Robotik?

Wenn wir Roboter bauen, fragen wir uns gleichzeitig: Wie denkt ein Mensch, wie funktioniert das Greifen, wie das Laufen? Und wieso ist es so schwierig, mit Maschinen Aufgaben nachzubauen, die Menschen scheinbar spielerisch lösen – zum Beispiel eine Küche aufräumen. Das ist mit Robotern noch nicht erreicht. Das lehrt uns auch sehr viel über die Komplexität dieser Aufgaben und über die unglaublichen Fähigkeiten des Menschen.

Können Sie verstehen, wenn Menschen humanoide Roboter mit künstlicher Intelligenz unheimlich finden?

Eine künstliche Intelligenz, die in der Robotik eingesetzt wird, wirkt in die reale Welt. Das ist etwas völlig anderes, als wenn die KI ein Chatbot ist, Texte erzeugt und vielleicht bei zwei von zehn Anfragen danebenliegt. So etwas darf in der Robotik nicht passieren. Sobald eine KI Maschinen steuert, sind die Anforderungen viel höher. Allgemein neigen Menschen dazu, humanoiden Robotern mehr Fähigkeiten zuzuschreiben, als sie tatsächlich haben. Die Sorgen hängen meistens mit einem Mangel an Informationen zusammen.

Je besser die Menschen die Robotik verstehen, desto geringer werden die Bedenken?

Genau. Im DLR stehen immer die Nutzerinnen und Nutzer im Vordergrund, wir entwickeln unsere Systeme menschenzentriert. Wir arbeiten zum Beispiel viel mit Personen mit Behinderungen zusammen, die von Robotern stark profitieren können. Wenn Schnittstellen so ausgelegt sind, dass die Leute die volle Kontrolle über das Geschehen haben, dann sind sie von den Robotern meistens begeistert. Wir entwickeln Roboter, die mit Menschen interagieren. Sie sind feinfühlig, nachgiebig, ermöglichen eine sichere physische Interaktion und reagieren auf einer Ebene, die auch für Laien verständlich ist.

Um eine KI zu trainieren, braucht es Daten. Woher kommen die?

Wir haben nicht Millionen von humanoiden Robotern in der realen Welt, die brauchbare Trainingsdaten liefern. Das ist ein großes Forschungsthema und anders als bei textbasierter KI, der quasi das ganze Internet zur Verfügung steht. Eine Robotik-KI kann aber zum Beispiel mit Daten aus einer Simulation trainiert werden. Da haben wir Erfolge erzielt und da ist in den nächsten Jahren einiges zu erwarten.

Liegt der Forschungsschwerpunkt eher in der Raumfahrt oder in der Assistenzrobotik?

Wir forschen für die Raumfahrt, das ist unser primäres Anwendungsfeld. Aber wir hatten von Anfang an den Technologietransfer im Blick. Wir führen schon seit 2017 Experimente zusammen mit Astronautinnen und Astronauten auf der Internationalen Raumstation ISS durch. In dem Szenario werden aus einem Orbit Roboter gesteuert, um auf der Oberfläche Habitate aufzubauen. Unsere Roboter arbeiten autonom, teilautonom oder als Avatar – je nach Vorgabe der Crew. Eine Anwendung auf der Erde ist naheliegend: Unsere Vision ist, dass man mit solchen Robotern die Selbstständigkeit von Menschen in den eigenen vier Wänden unterstützt. Hier haben wir eine zentrale Rolle zwischen dem akademischen Umfeld und dem Technologietransfer zum Aufbau eines Marktes.

Enge Zusammenarbeit von Robotern und Menschen

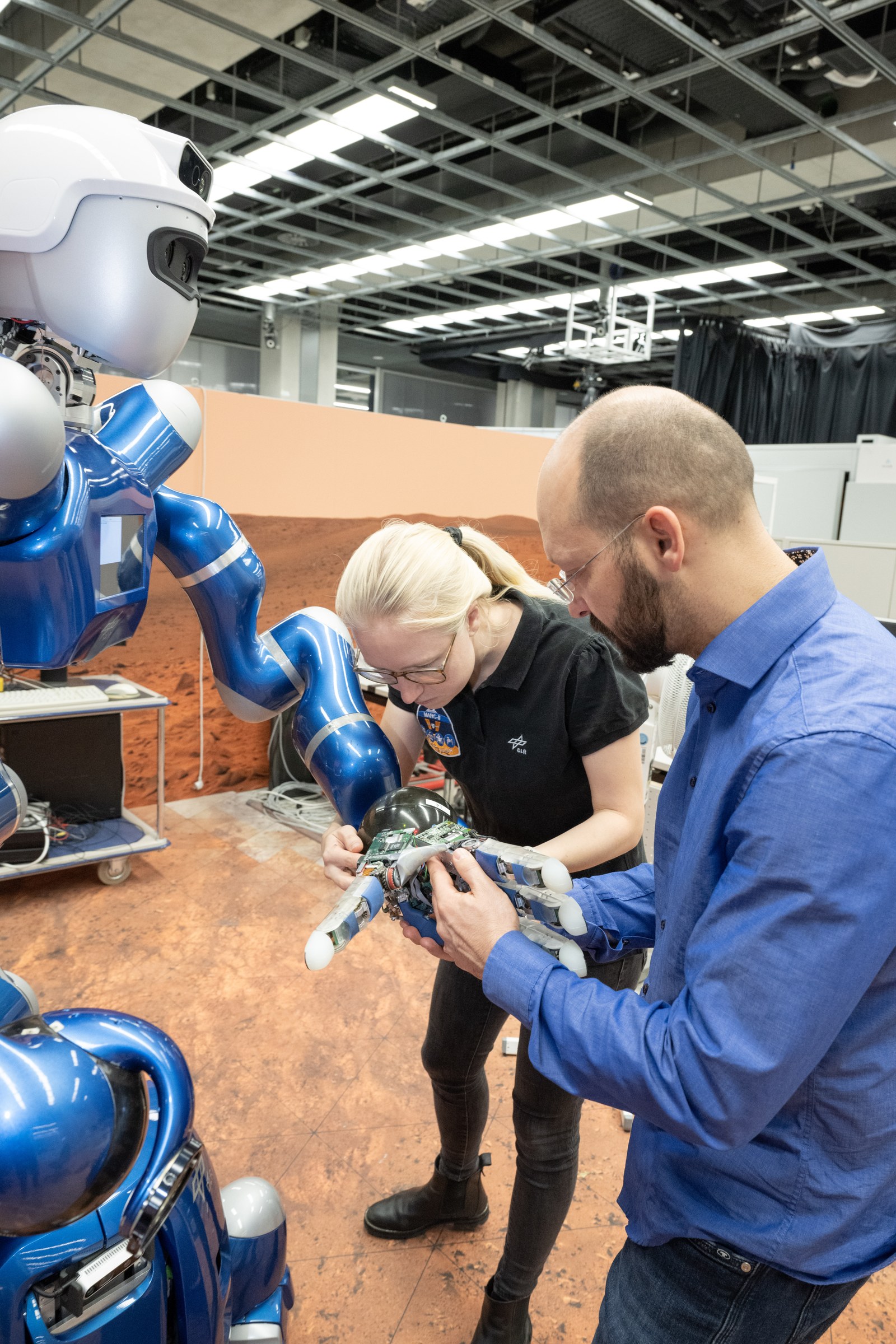

Anne Köpken hat Elektrotechnik an der TU München studiert, im zweiten Semester besuchte sie auf einer Exkursion das DLR. „Ich fand es supercool und wollte hier arbeiten“, sagt sie. Gerade schreibt sie ihre Doktorarbeit in der Robotik. Ihr Schwerpunkt liegt bei Rollin' Justin. Er ist der„Zwillingsbruder“ von Agile Justin, aber mit etwas anderen Fähigkeiten. Während Agile Justin Spezialist in feinfühligem Manipulieren mit KI ist, tendiert Rollin' Justin eher in die Servicerobotik und Weltraumerkundung.

Als Rollin' Justin im Juli 2023 von der Internationalen Raumstation ISS ferngesteuert wurde, war Anne Köpken dabei. In dem Szenario entlud der Roboter im Oberpfaffenhofener Marslabor einen Lander und platzierte ein Messgerät auf dem Boden. NASA-Astronaut Frank Rubio steuerte Rollin' Justin, den robotischen Lander und einen Roboter der Europäischen Weltraumorganisation ESA gleichzeitig. Der Astronaut konnte per Knopfdruck aus dem All entscheiden, wie autonom die Roboter arbeiten. Die Zusammenarbeit von humanoiden Robotern und Menschen bei Erkundungsmissionen wird im DLR schon lange erprobt, der Schwierigkeitsgrad steigt kontinuierlich. Roboter können zum Beispiel eingesetzt werden, wenn es für Menschen zu gefährlich ist.

Doch auch auf der Erde eröffnen sich für Rollin' Justin Möglichkeiten. Er könnte einen Job als mobiler Assistenzroboter übernehmen und Menschen helfen, die auf Unterstützung angewiesen sind. Das ist ein weiterer Schwerpunkt der Forschung zur Mensch-Roboter-Kooperation am DLR. Anne Köpken entwickelt neue Fähigkeiten für Rollin' Justin: „Das System an sich ist faszinierend und vielfältig. Neben dem Space-Projekt gibt es die Anwendungen, bei denen der Nutzen für die Menschen auf der Erde direkt sichtbar wird.“

Das System an sich ist faszinierend und vielfältig. Neben dem Space-Projekt gibt es die Anwendungen, bei denen der Nutzen für die Menschen auf der Erde direkt sichtbar wird.

Mit „Gefühl“ für sich und andere

Für robotische Systeme wie Justin wird Fachwissen gebraucht: Mechanik, Elektronik, Informatik, Maschinenbau. Dazu kommen Fragen aus der Psychologie und Ethik. Dass die humanoiden Roboter sich koordiniert bewegen, ist eine Aufgabe für die Regelungstechnik. Sie haben Drehmoment-Sensoren in den Gelenken, wissen also nicht nur, wie ihr Körper ausgerichtet ist, sondern sind auch feinfühlig. Das heißt, sie spüren, mit welcher Kraft etwas gegen sie drückt. Dann können sie sich zum Beispiel nachgiebig machen und ziehen ihren Arm zurück. Justin ist außerdem ein Multitasking-System, er macht verschiedene Dinge gleichzeitig. Diese müssen so koordiniert werden, dass Justin die wichtigeren Aufgaben sicherer und eher ausführt.

Doch in Oberpfaffenhofen sind nicht nur Agile und Rollin' Justin zuhause. Mittlerweile „wohnen“ vier humanoide Roboter in den Laboren des Instituts. Und sie lernen stetig dazu, wie und wo sie den Menschen unterstützen und entlasten können.

Eine ganz normale Roboter-WG

Agile Justin und Rollin' Justin sind nicht die einzigen humanoiden Roboter im DLR-Institut für Robotik und Mechatronik. Nebenan im Labor befinden sich David und Toro. Die robotische „Familie“ wächst mit ihren Aufgaben. Die „Wohngemeinschaft“ hat sogar ein „Haustier“ – Bert ist ein robotischer Vierbeiner, mit dem die Fortbewegung von Tieren erforscht und nachgeahmt wird.

Ein Beitrag von Katja Lenz aus dem DLRmagazin 174