Haptic Rendering: Collision Detection and Response

Realitätsnahe Bilder können heutzutage in interaktiven virtuellen Simulationen erzeugt werden. Der nächste Schritt hin zu einer noch realistischeren Erfahrung virtueller Umgebungen erfordert eine intuitive Objektmanipulation; dazu spielt die Kollisionsrückkopplung eine entscheidende Rolle.

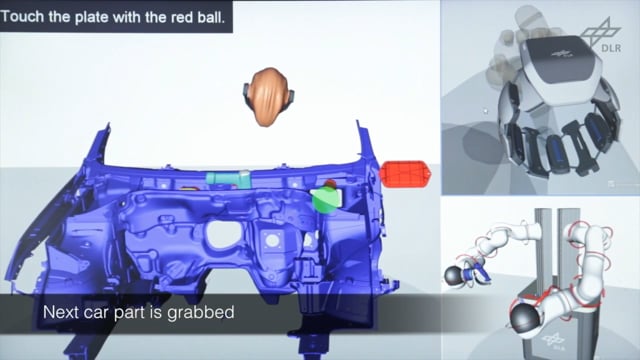

Die Gruppe für Telepräsenz und Virtuelle Realität des Deutschen Zentrums für Luft- und Raumfahrt forscht an haptischen Algorithmen, die solche virtuelle Szenarien mit Kollisionsrückkopplung ermöglichen. Der Benutzer kann komplexe virtuelle Objekte in Echtzeit dank unseres haptischen Eingabegerätes HUG manipulieren; Immer wenn virtuelle Objekte miteinander kollidieren, spürt der Benutzer die entsprechenden Kollisionskräfte. Folgendes Video zeigt eine solche haptische Rückkopplung am Beispiel einer Einbaumontagesimulation:

A Platform for Bimanual Virtual Assembly Training with Haptic Feedback in Large Multi-Object Environments

Für die Wiedergabe dieses Videos auf Vimeo.com ist Ihre Zustimmung zur Speicherung von Daten ('Cookies') erforderlich. Unter Datenschutz-Einstellungen können Sie Ihre Wahl einsehen und verändern.

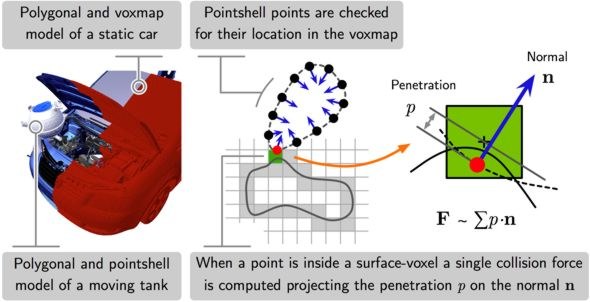

Im Vergleich zum graphischen Rendern, das für eine stabile und flüssige Darstellung einen 30 Hz-Takt benötigt, müssen haptische Signale in einer herausfordernden Frequenz von 1000 Hz erzeugt werden, um eine realistische und stabile Rückkopplung zu schaffen. Dafür wird ein Algorithmus entwickelt, der zwei Datenstrukturen verwendet: voxelisierte Abstandsfelder (Voxmaps) und Punkt-Kugel Hierarchien (Pointshells). Unsere Forschung basiert auf dem Voxmap-Poinsthell (VPS) Algorithmus, der echtzeitige Kollisionsrückkopplung auch mit Millionen von Dreiecken ermöglicht.

Mit Hilfe virtueller Umgebungen mit haptischer Rückkopplung ist es beispielsweise möglich

- in frühen Phasen der Produktentwicklung herauszufinden, ob Teile optimal einbaubar sind,

- das Wissen von erfahrenen Mechanikern in den Konstruktionsprozess einzubringen,

- und Mechaniker für zukünftige Einbauaufgaben zu trainieren.

Verwandte Interessante Links

Studentenstellen

- On-Orbit Servicing in virtuellen Umgebungen mit haptischem Feedback

- Datenstrukturen zur Kollisionserkennung und Kraftberechnung

- Haptisches Rendern in virtuellen Umgebungen: Evaluierung und Verbesserungen

Ausgewählte Veröffentlichungen

- M. Sagardia, A. Martín, T. Hulin: Realtime Collision Avoidance for Mechanisms with Complex Geometries (Video), IEEE VR, 2018

- M. Sagardia, T. Hulin: Multimodal Evaluation of the Differences between Real and Virtual Assemblies, IEEE Transactions on Haptics (ToH), 2017

- M. Sagardia, T. Hulin: A Fast and Robust Six-DoF God Object Heuristic for Haptic Rendering of Complex Models with Friction, ACM VRST 2016, 2016, Munich, Germany

- M. Sagardia, K. Hertkorn, T. Hulin, S. Schätzle, R. Wolff, J. Hummel, J. Dodiya, A. Gerndt: VR-OOS: The DLR's Virtual Reality Simulator for Telerobotic On-Orbit Servicing with Haptic Feedback, IEEE Aerospace Conference, Big Sky, Montana, USA, 2015

- M. Sagardia, T. Hulin: Fast and Accurate Distance, Penetration, and Collision Queries Using Point-Sphere Trees and Distance Fields, SIGGRAPH, 2013

- M. Sagardia, B. Weber, T. Hulin, C. Preusche, G. Hirzinger: Evaluation of Visual and Force Feedback in Virtual Assembly Verifications, IEEE VR (Honorable Mention), 2012

- R. Weller, M. Sagardia, D. Mainzer, T. Hulin, G. Zachmann, C. Preusche: A Benchmarking Suite for 6-DOF Real Time Collision Response Algorithms, VRST, 2010

- M. Sagardia, T. Hulin, C. Preusche, G. Hirzinger: Improvements of the Voxmap-PointShell Algorithm — Fast Generation of Haptic Data-Structures, IWK, 2008