THR-Datensatz

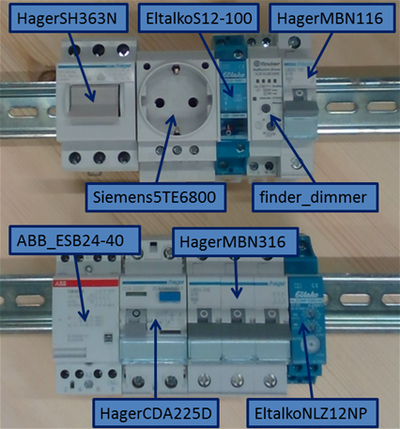

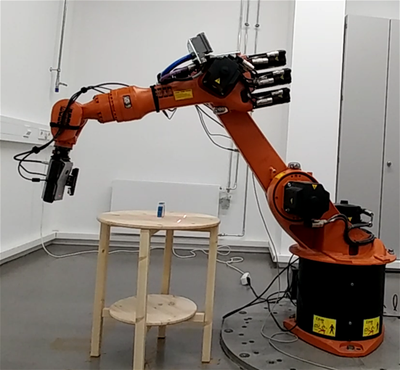

Der THR-Datensatz (Top Hat Rail) besteht aus RGB- und Tiefenbildern, die mit der Intel Real Sense SR300 (SR300) sowie der Asus Xtion (Xtion) in Kombination mit dem KUKA-Industrieroboter KR16 erfasst wurden. Daten von neun industriellen Hutschienenobjekten in vier verschiedenen Szenen mit unterschiedlichen Kombinationen dieser Objekte (auch doppelte Instanzen) wurden generiert. Die Objekte können ganz einfach von einem Benutzer auf der Website des jeweiligen Herstellers bestellt werden, z. B. um die Leistung der Objekterkennung und -manipulation in einer realen Umgebung zu testen.

Das Objekt oder die Objektszene wurde(n) bei der Aufnahme auf einem runden Tisch platziert und Bilder werden aus 200 verschiedenen Positionen, welche gleichmäßig auf einer Halbkugel (mit verschiedenen Abständen zum Objekt) verteilt sind, aufgenommen. Um zusätzliche Variationen zu erhalten, wird die Kamerarotation für jeden Blickpunkt zufällig verändert. Die vier unterschiedlichen Kamerarotationen (angezeigt durch die unterschiedlich gefärbten Punkte) wurden aufgrund des Roboter-Arbeitsbereichs verwendet: Die Sensoren werden in 90-Grad-Schritten um den Blickstrahl gedreht und Bilder hochkant, auf den Kopf gestellt und nach links und rechts gedreht ausgerichtet.

Die SR300 wurde wegen ihrer Fähigkeit ausgewählt, Tiefenbilder im Nahbereich bis 200 mm aufzunehmen. Für die einzelnen Objekte wurden deshalb Bilder in einem Abstand von 300 mm und 600 mm von der SR300 aufgenommen. Zusätzlich wurden die Objekte mit der Xtion in einem Abstand von 600mm (aufgrund des Arbeitsbereichs des Sensors) aufgenommen. Für die Szenen, die zu Testzwecken verwendet werden können, werden Bilder in einem Abstand von 450 mm von der SR300 und 600 mm von der Xtion aufgenommen. Darüber hinaus wurden Ground-Truth-Modelle der einzelnen Objekte und Objekte in den Szenen in hoher Qualität mithilfe eines Laser Stripers generiert.

Download

Die einzelnen Dateien des THR-Datensatzes können von

heruntergeladen werden.

Die einzelnen Ordner, die die Daten für jedes Objekt (z. B. ABB_ESB24-40) oder Szene (z. B. scene1) enthalten, werden in den folgenden Abschnitten erläutert.

Für jedes Objekt wurden 200 Messungen auf einer Halbkugel um das Objekt mit unterschiedlichen Abständen erfasst (etwa 300 und 600 Millimeter), woraus 2 Ordner entstanden:

- dist300 (SR300)

- dist600 (SR300 und Xtion)

Alle Messungen/Werte sind in Millimetern angegeben.

Für die Objekt-Szenen wurden dieselben 200 Messungen mit einem anderen Radius mit der SR300 für Testzwecke erfasst:

- dist450 (SR300)

- dist600 (Xtion)

Jeder Objekt-/Szenendatensatz enthält:

- depth: Tiefenbilder XXX.png als mono16 bit pngs, diese müssen mit dem Tiefenskalierungsfaktor 0,124987 multipliziert werden, um die Werte in Millimetern zu erhalten (um die Genauigkeit zu erhöhen).

- rgb: rgb-Bilder XXX.png

- poses: Position XXX.tcp.coords des Roboter-TCP als homogene Matrix mit zeilenweiser Anordnung (die letzte Zeile 0 0 0 1 wird nicht gespeichert).

- masks: Die bereitgestellten Segmentierungsmasken stellen den in den Tiefen- oder RGB-Bildern sichtbaren Teil des Objekts dar (für die Xtion nur eine Maske für beides, da Tiefe und Farbe abgestimmt sind). Darüber hinaus wird für die Szenen für jedes einzelne Objekt eine individuelle Maske bereitgestellt.

Um die Position des Sensors zu erhalten, muss die Position des Roboter-TCP mit der in der Kalibrierungsdatei angegebenen extrinsischen (Hand-Augen) Transformation multipliziert werden. Um die Transformation der Tiefenkamera für die SR300 zu erhalten, ist dies camera0 und für Xtion camera1 (da für die Xtion Farbe und Tiefe abgestimmt wurden; für die SR300 ist die Transformation in der Kalibrierungsdatei angegeben). Das Skript convert2PointCloud.py enthält ein Beispiel für die Berechnung einer Punktwolke aus den Daten.

Darüber hinaus wurden für alle Objekte/Szenen Ground-Truth-Modelle (mit einem Laser Striper) erstellt und in dem folgenden Ordner gespeichert:

- model: Dieser Ordner enthält die Ground-Truth-Modelle (in geringer sowie hoher Auflösung), die mit einer ground-truth-homogenen Matrix-Transformation für das Objekt/die Szene in der *.mat-Datei zentriert sind.

Für die Szenen wird ein Ground-Truth-Gitter mit Transformationsdatei für alle Objekte in der Szene bereitgestellt.

Die intrinsische und extrinsische Kamerakalibrierung ist enthalten in:

- calibration: Kalibrierungsdatei erstellt mit dem DLR-Tool CalDe und CalLab, für Einzelheiten zu dem Kalibrierungstool und dem Kalibrierungsdateiformat siehe DLR CalDe und CalLab

Verwendung des THR-Datensatzes

Bitte zitieren Sie unsere Publikation, wenn Sie den THR-Datensatz in Ihrer Forschung nutzen:

@INPROCEEDINGS{Durner2017dataset, title = {Experience-based Optimization of Robotic Perception}, author = {Durner, Maximilian and Kriegel, Simon and Riedel, Sebastian and Brucker, Manuel and Marton, Zoltan-Csaba and Balint-Benczedi, Ferenc and Triebel, Rudolph}, booktitle = {IEEE International Conference on Advanced Robotics (ICAR)}, month = {July}, year = {2017}, address = {Hongkong, China}

Lizenz

Alle Datensätze auf dieser Seite sind urheberrechtlich durch uns geschützt und unter der Creative Commons Attribution-ShareAlike 4.0 Lizenz (Creative Commons Attribution-ShareAlike 4.0 International License) veröffentlicht. Dies bedeutet, dass Sie die Autoren in der oben angegebenen Weise angeben müssen und die resultierende Arbeit nur unter derselben Lizenz verbreiten dürfen.