Optische Navigation

Motivation

Zukünftige Explorationsmissionen benötigen fortgeschrittene Fähigkeiten wie die einer präzisen und sicheren Landung auf planetaren Körpern oder der Durchführung von Rendezvous und Docking-Operationen. Viele dieser Missionen werden sowohl in der Erd- und Mondumgebung stattfinden, als auch bei weit entfernten Zielen wie dem Mars oder den Eismonden von Jupiter und Saturn. Für eine zuverlässige Operation ist sowohl Autonomie des Raumfahrtzeuges nötig, als auch die Verwendung des Zielkörpers als Navigationsreferenz. Als vielversprechend für die Umsetzung dieses Konzepts gilt die Verwendung von Methoden und Technologien der optischen Navigation. Wenig überraschend muss für diese modernen Ansätze ein deutlich höherer Grad an Details über das Missionsziel an Bord verarbeitet werden. Diese stammen zum einen aus Daten aktueller Kartierungsmissionen, aus denen beispielsweise Kataloge mit georeferenzierten Landmarken abgeleitet werden können. Ergänzt werden solche a priori Informationen mit Messungen die im Verlauf der Mission gemacht werden, sie finden Anwendung z.B. für den Abgleich mit einem an Bord vorhandenen Landmarkenkatalog oder zur Beurteilung der Beschaffenheit des Landegebiets. Aus allen diesen Anwendungen ergibt sich der Bedarf nach deutlich verbesserter Rechenkapazität, nach neuartigen optischen Sensoren und nach komplexen Algorithmen zur Verarbeitung der durch sie gelieferten Daten.

Aus dieser Motivation heraus arbeitet das DLR-Institut für Raumfahrtsysteme in verschiedenen Bereichen der optischen Navigation für Raumfahrtanwendungen.

Übersicht unserer Forschungsaktivitäten im Bereich optische Navigation

Unsere Aktivitäten im Bereich optische Navigation umfassen hauptsächlich:

- Entwicklung von Sensorik für optische Navigation

- Integration von Sensorik für optische Navigation in GNC-Systeme

- Test dieser Systeme in unseren Testanlagen

- Test von GNC-Systemen als Service für Entwicklungen Dritter

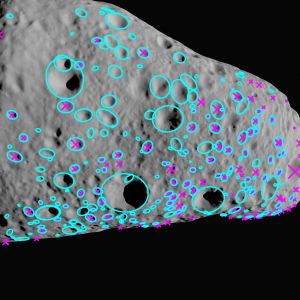

Kraternavigation

Das DLR entwickelt einen Sensor welcher seine Position und Lage gegenüber jedem Himmelskörper, welcher Krater aufweist und kartiert ist, anhand von von Einzelbildaufnahmen bestimmen kann. Integriert in ein GNC System ermöglicht der Sensor, über die Ausgabe von Messung von absoluter Position und Lage, eine autonome Navigation und z.B. die Durchführungen präziser Landungen. Die wesentlichen Arbeitsschritte innerhalb des Sensors sind:

- Bildaufnahme: es wird ein Bild des Zielobjekts aufgenommen

- Kratererkennung: innerhalb dieses Bildes liegende Krater werden erkannt

- Identifikation: anhand der erkannten Krater werden einzigartige Krater-Konstellationen durch Abgleich mit einem Katalog erkannt, daraus können auch die Krater selbst identifiziert werden

- Posenschätzung: die Feststellung der eigene Position und Orientierung gegenüber dem Zielkörper, abgeleitet aus den Positionen der Krater auf dem Zielkörper und innerhalb des Bildes, sowie aus den Kameraparametern.

Der Kraternavigations-Sensor arbeite über einen weiten Bereich von Blickwinkel und Sonnenstand. Sind die Bildaufnahmebedingungen erfüllt, genügt ein einziges Bild für die Ermittlung der eigenen Pose gegenüber dem Zielkörper.

Die Sensorhardware umfasst eine Kameraeinheit für die Bildaufnahme und eine Elektronikeinheit für die on-board Bildverarbeitung und -ablage, sowie die Vorhaltung des Kraterkatalogs. Die Hardware erlaubt die autonome Ermittlung der eigenen Position und Lage in Echtzeit.

Auf dem Demonstrator wurde die zugehörige Kraternavigationssoftware innerhalb der repräsentativen Umgebung von TRON getestet. Damit wurde der Sensor auf einen Technologie-Reifegrad von 4 qualifiziert. Darüber hinaus ist der Sensor sehr gut für eine Integration in typische Navigationsfilterarchitekturen und GNC-Systeme geeignet. Das wurde in verschiedenen Flugversuchen des Projekts ATON gezeigt. in diesem Projekt wurden die inertialen Messungen einer IMU mit denen der Kraternavigation erfolgreich in einem Kalmanfilter fusioniert. Die Navigationslösung aus der Datenfusion wurde erfolgreich für die Echtzeit-Flugführung des Versuchshubschraubers eingesetzt.

Die Algorithmik der Kraternavigation ist mittlerweile auf synthetischen Bildern, Bildern von realistischen Modellen im Labor und auf Bildern von Flugversuchen validiert worden.

Star Tracker

Unabhängig von der Position einer Kamera im Sonnensystem sind Bilder vom Sternenhintergrund aufgrund der extremen Entfernungen praktisch identisch, solange sie mit derselben Blickrichtung aufgenommen werden.

Dieser Fakt wird vielfach für die Lagebestimmung in der Raumfahrt ausgenutzt, im Allgemeinen mit Hilfe von Star Trackern. Solch ein Sensor ermittelt die eigene Orientierung gegenüber dem Sternenhintergrund über die Identifizierung von Sternen in Kamerabildern unter Verwendung eines Kataloges. Über weitere Verarbeitungsschritte kann daraus die Orientierung gegenüber der Erde ermittelt werden.

Im Rahmen des SHEFEX II-Projektes wurde in der Abteilung für Navigations- und Regelungssystem ein Star Tracker für die Anwendung in Höhenforschungsraketen entwickelt.

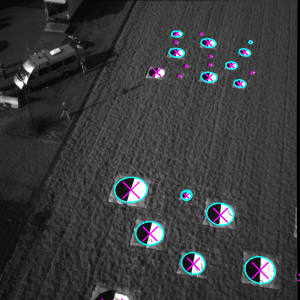

Tag Navigator

Der Tag Navigator ist ein Sensor welcher die eigene Position und Lage gegenüber einer Fläche misst, die mit bestimmten Markern ausgestattet ist. Momentan wird der Sensor im EAGLE Projekt verwendet, zur Unterstützung des GNC-Systems bei Hover-Demonstrationsflügen.

Der Sensor besteht aus zwei Komponenten, einmal dem Panel welches mit Markern (basierend auf dem AprilTag Design) bedruckt ist, und dem Sensor, welcher eine Kamera und eine Prozessierungseinheit umfasst. Wenn die 3D Positionen der Marker und die intrinsischen Parametern der Kamera bekannt sind, kann aus einem Kamerabild die Pose der Kamera relativ zu den Markern über die Perspective-n-Point Methode ermittelt werden.

Integration von Sensorik für optische Navigation in GNC-Systeme

In der Regel kann ein einzelner Sensor einen Teil des Raumfahrzeugzustandes messen, wie z.B. die Position, seine Geschwindigkeit oder seine rotatorische Lage relativ zu einem äußeren Bezugssystem. Kombiniert man die Messungen mehrerer Sensoren, lässt sich dadurch der vollständige Zustand ermitteln. Im Forschungsbereich der optischen Navigation arbeiten wir daran, die Daten der optischen Sensoren mit denen von Inertialsensoren und weiteren Sensoren (z.B. Radar, Magnetometer) zu einer Navigationslösung zu fusionieren.

Aktuelle Arbeiten

Wesentliche Arbeiten zu diesem Thema laufen im DLR-Projekt ATON. Dort werden Messdaten von Inertialen Messeinheiten (englisch: Inertial Measurement Unit, IMU), Star Tracker, Kamera- (Kraternavigation und Feature Tracking) und Flash Lidar-Sensoren zu einer Echtzeit-Navigationslösung fusioniert.

Weitere Arbeiten laufen für die Unterstützung der Navigation des EAGLE Landedemonstrators.

Zurückliegende Arbeiten

Hardware-in-the-Loop Test von Sensorik und GNC-Systemen in TRON

Sensorik und GNC-Systeme für Raumfahrtanwendungen erfordern eine hohe Zuverlässigkeit. Eine solche lässt sich nur durch kontinuierliches Testen der Technologie erreichen. Speziell für das Testen von Technologien höherer Reifegrade im Bereich TRL 4-6 wurde am DLR-Institut für Raumfahrtsysteme das Testbed for Robotic Optical Navigation (TRON) eingerichtet. Es ist dort möglich Komponenten und Systeme auf Breadboard-Level bis hin zum fertigen Flugmodell zu testen.