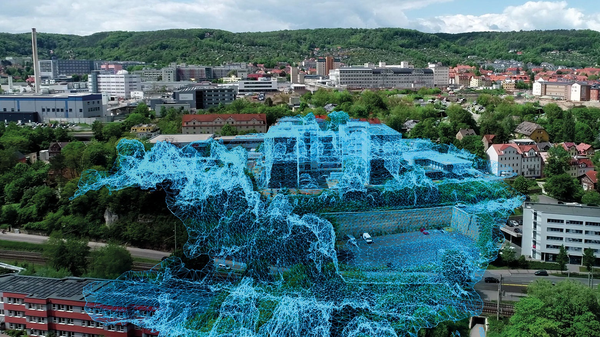

Institut für KI-Sicherheit

Im Institut für KI-Sicherheit erforschen und entwickeln wir KI-bezogene Methoden, Prozesse, Algorithmen, Technologien und Ausführungs- bzw. Systemumgebungen. Unser Fokus liegt auf sicherer und norm- bzw. standardkonformer KI, Cybersicherheit in offenen Daten- und Dienste-Ökosystemen und KI, sowie der Automatisierung in Mobilität und Logistik.