KIFAHR: KI-basierte Vertikaldynamik-Steuerung

Im Automobilbereich besteht das Ziel der Vertikaldynamikentwicklung darin, die Fahrwerksaufhängung des Fahrzeugs so zu optimieren, dass bestimmte Ziele wie Fahrkomfort und Fahrzeugstabilität erreicht werden. Das Hauptziel ist die gleichzeitige Maximierung des Fahrkomforts für die Fahrzeuginsassen und der Straßenhaftung der Reifen. Um einen höheren Automatisierungsgrad beim Reglerentwurf zu erreichen, sind neuartige Regelungsansätze erforderlich. Dabei sollten verschiedene Einflussfaktoren wie variable Lasten, unterschiedliche Fahrbahnoberflächen, Reifentypen, Reifendrücke und Wetterbedingungen berücksichtigt werden. Um dieses Ziel zu erreichen, haben sich der Fahrwerkshersteller KW automotive GmbH und die DLR-Abteilung Fahrzeug Systemdynamik und Regelungstechnik im Projekt KIFAHR zusammengeschlossen.

KIFAHR: KI-basierte Vertikaldynamik-Regelung

Für die Wiedergabe dieses Videos auf Youtube.com ist Ihre Zustimmung zur Speicherung von Daten ('Cookies') erforderlich. Unter Datenschutz-Einstellungen können Sie Ihre Wahl einsehen und verändern.

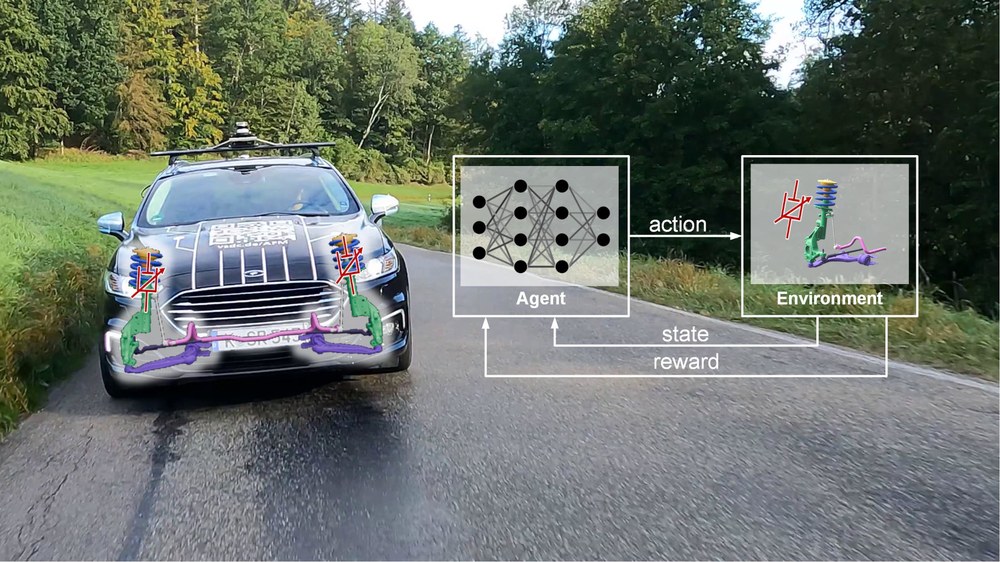

Im Rahmen des Projekts wurde das Potenzial intelligenter Lernmethoden, insbesondere des Reinforcement Learning (RL), für die Steuerung semi-aktiver Dämpfer im Fahrwerksbereich aufgezeigt. Methoden des Reinforcement Learning stellen einen vielversprechenden Ansatz dar, um das Regelgesetz durch automatisierte Prozesse zu erlernen. Mehrere Veröffentlichungen haben die Leistungsfähigkeit von Reinforcement Learning im Bereich der Regelungstechnik vor allem für aktive Stellgrößen gezeigt. Die Anwendung von RL-Methoden auf semi-aktive Vertikaldynamiksysteme ist jedoch ein neues Forschungsgebiet.

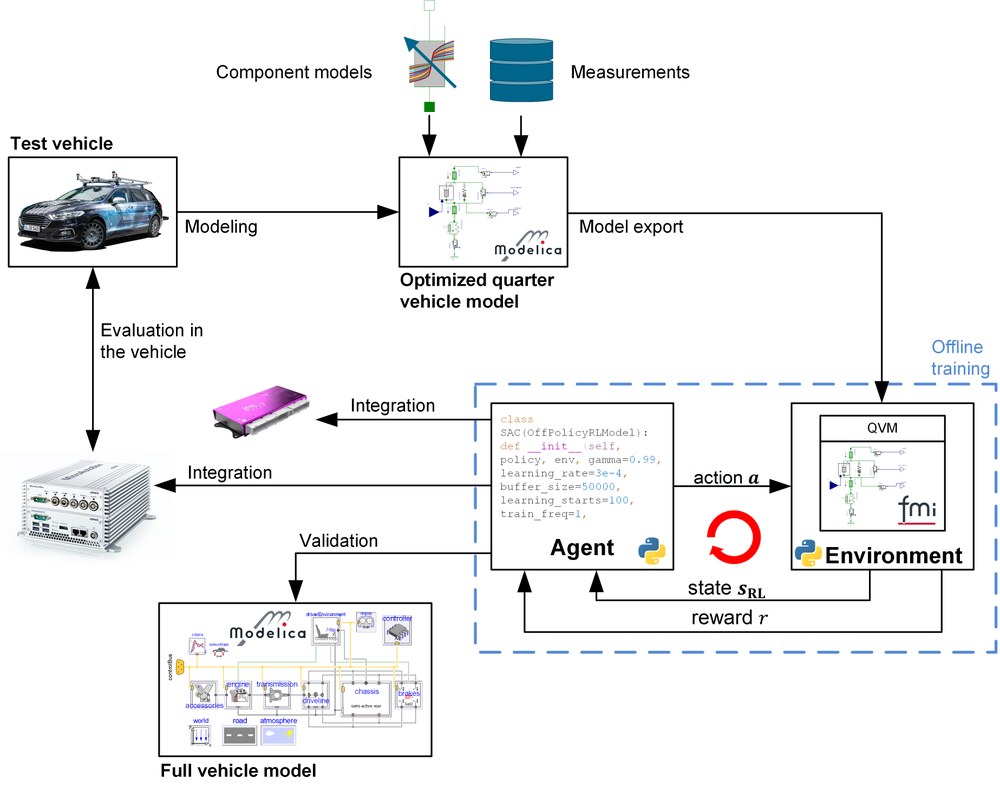

Für das Training des Reglers, den Export des neuronalen Netzes des Reglers und die Validierung des Reglers wurden neue Software-Werkzeugketten entwickelt oder bestehende Werkzeugketten umfassend erweitert und für den Anwendungszweck angepasst. Das Trainingsmodell wurde validiert und in die neu angepasste RL- Werkzeugketten aufgenommen. Die Werkzeugketten ist in der Lage, RL-Algorithmen automatisch in verschiedenen Umgebungen zu trainieren, einschließlich verschiedener Trainingsszenarien, und die resultierenden Agenten anhand bestimmter Bewertungsmetriken und Szenarien zu vergleichen. Nach mehrmaliger Wiederholung und Optimierung des Trainingsprozesses wurden die besten Agenten für die Validierung an einem Gesamtfahrzeugmodell ausgewählt. Um die Leistung des erlernten Reglers zu bewerten, wurde der Agent als C-Code exportiert und in ein Rapid-Control-Prototyping-System integriert. In einem letzten Schritt wurde die Leistung des gelernten Reglers auf dem Seven-Post-Stempelprüfstand evaluiert und mit einem modernen kombinierten Skyhook & Groundhook Regler verglichen. Um einen angemessenen Vergleich zu erhalten, wurden die Parameter des Skyhook & Groundhook Reglers auch durch numerische Optimierung der Trainingsmodelle des Regelsystems ermittelt. Zusammenfassend lässt sich sagen, dass im Rahmen des Projekts ein neuer und leistungsfähiger KI-basierter Regler für die Vertikaldynamik entwickelt und mittels einer Toolbox zur Codegenerierung für neuronale Netze auf einem fahrzeuginternen Mikrocontroller implementiert wurde. Um die sichere Ausführung des Reglers gewährleisten zu können, wurde ein Sichheitskonzept entwickelt und in realen Fahrversuchen getestet.

Die Leistung des mit Hilfe eines validierten Streckenmodells erlernten RL-basierten Reglers wurde sowohl qualitativ in realen Fahrversuchen als auch quantitativ durch Messungen auf dem Seven-Post-Stempelprüfstand bestätigt. Zusammenfassend lässt sich sagen, dass Methoden des Reinforcement Learning für die Regelung der Vertikaldynamik bei einer Vielzahl von Fahrmanövern qualitativ und quantitativ besser abschneiden können als der Stand der Technik. Die Ergebnisse des Projekts zeigen das Potenzial von RL-Methoden für Vertikaldynamikregelung Anwendungen. Im Rahmen des Projekts wurden neue leistungsstarke Software-Tools und leistungsfähige Hardware entwickelt, die den RL-Designprozess unterstützen und einen sicheren Betrieb gewährleisten. Weitere Forschung wird sich mit der Verfeinerung des gesamten Prozesses mit Technologien wie dem physics informed learning befassen.

Literatur: Projektbericht

Weiter Informationen finden Sie unter hier.