StereoInstancesOnSurfaces

Der Stereo Instances on Surfaces Datensatz (STIOS) soll die Evaluierung von Instanz-basierenden Algorithmen ermöglichen. Es ist ein repräsentativer Datensatz, um eine einheitliche Vergleichbarkeit für Instanz-Detektion und -Segmentierung mit unterschiedlichen Eingangs-Modalitäten (RGB, RGB-D, stereo RGB) zu erreichen. STIOS ist hauptsächlich für robotische Anwendungen (z.B. Manipulation von Objekten) gedacht, weshalb sich der Datensatz auf horizontale Oberflächen bezieht.

Download

Der Datensatz kann über Zenodo heruntergeladen werden:

https://zenodo.org/record/4706907.

Code-Utilities sind auf GitHub verfügbar:

https://github.com/DLR-RM/stios-utils.

Sensoren

STIOS enthält Aufnahmen von zwei unterschiedlichen Sensoren: einem rc_visard 65 color und einer Stereolabs ZED Kamera. Für beide Sensoren werden neben stereo RGB (linkes und rechtes RGB-Bild) auch die intern generierten Tiefenkarten gespeichert. Zusätzlich stellt der ZED-Sensor Normalenbilder sowie Punktwolkendaten zur Verfügung, welche in STIOS auch bereitgestellt werden. Da manche Objekte/Oberflächen wenig Textur aufweisen und dies die Qualität der Tiefenkarte negative beeinflussen würde, wird bei der Aufnahme der Tiefenbilder auf einen zusätzlichen LED-Projektor mit zufälligem Punktmuster zurückgegriffen (nur für rc_visard 65 color verwendet). STIOS beinhaltet deshalb für den rc_visard 65 color Stereo-RGB-Bilder und die daraus resultierenden Tiefenkarten sowohl mit als auch ohne projiziertem Pattern.

Durch die Vielzahl verschiedener Eingangsmodalitäten soll eine Vergleichbarkeit unterschiedlichster Methoden ermöglicht werden. Wie in der Abbildung zu sehen wurde der ZED-Sensor oberhalb der rc_visard 65 Objektive montiert, um einen ähnlichen Blickwinkeln zu erhalten. Dies ermöglicht eine Evaluierung zwischen den Sensoren, wodurch Aussagen über die Generalisierung der Methode bzgl. Sensoren oder der Qualität der Eingangsmodalität gemacht werden können.

Objekte

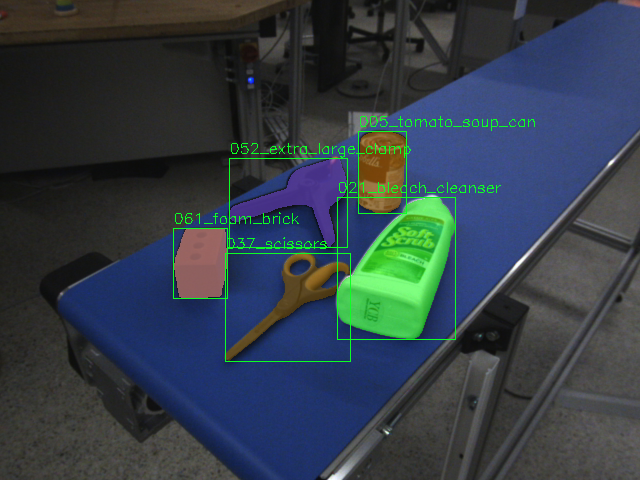

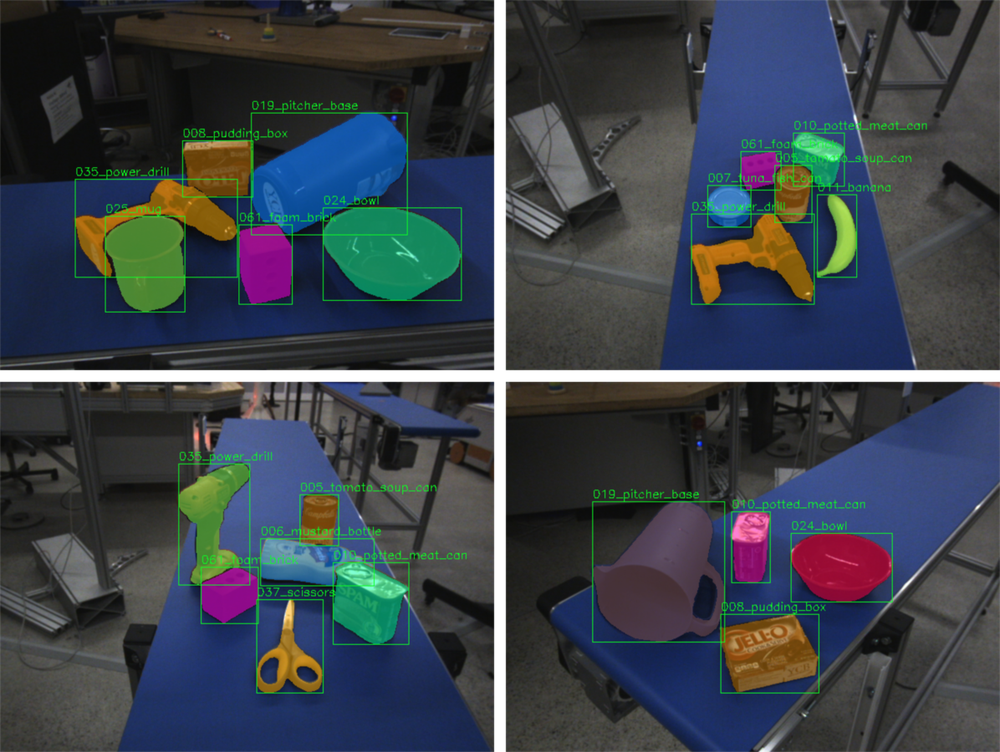

Damit mehrere Anwendungsbereiche von unbekannter Instanzsegmentierung, aber auch die weit verbreiteten Instanzdetektion, -segmentierung (Detektion + Klassifizierung), abgedeckt werden können, beinhaltet der Datensatz Objekte aus dem YCB Video dataset:

003_cracker_box, 005_tomato_soup_can, 006_mustard_bottle, 007_tuna_fish_can, 008_pudding_box, 010_potted_meat_can, 011_banana, 019_pitcher_base, 021_bleach_cleanser, 024_bowl, 025_mug, 035_power_drill, 037_scissors, 052_extra_large_clamp, 061_foam_brick.

Durch die weitverbreitete Verwendung dieser Objekte in robotischen Anwendungen gibt es für jedes der Objekte 3D Modelle, welche zur Generierung von synthetischen Trainingsdaten für z.B. Instanzdeketion basierend auf RGB-D verwendet werden können. Um ein gleichverteiltes Auftreten der 15 Objekte zu garantieren, werden für jedes Sample 4–6 zufällige Objekte machinell ausgewählt. Die Ausrichtung der Objekte ist dabei entweder leicht (Objekte berühren sich nicht) oder schwer (Objekte dürfen sich berühren oder aufeinander liegen).

Umgebungen

Der Datensatz beinhaltet 8 unterschiedliche Umgebungen, um die Variation von Umgebungsparameter wie Beleuchtung, Hintergrund oder Szenenoberflächen abzudecken. In folgenden Umgebungen wurden Szenen für den Datensatz aufgenommen: office carpet, workbench, white table, wooden table, conveyor belt, lab floor, wooden plank und tool cabinet.

Bei der Wahl der Szenen wurde darauf geachtet, dass diese für Stereo-Sensoren freundliche als auch anspruchsvolle Oberflächen beinhaltet. STIOS enthält deshalb sowohl texturarme (z.B. white table, conveyor belt) als auch texturreichen Oberflächen (z.B. lab floor, wooden plank). Durch die genannten Variationen der Oberflächen sowie Umgebungen kann die Robustheit als auch die Generalisierung der Methoden gegenüber verschiedener Umgebungsparameter evaluiert werden.

Für jede Szenenoberfläche werden aus 4 manuell eingestellten Kamerablickwinkel (ca. 0.3–1m Entfernung) jeweils 3 leichte und 3 schwierige Samples generiert. Wie die Abbildung zeigt, kann es in manchen Kamerablickwinkeln auch bei der leichten Objekt-Ausrichtung zu Verdeckungen kommen. Die 6 Samples je Kameraeinstellung ergeben schließlich für jeden Sensor 24 Samples pro Umgebung, was zu einer Gesamtzahl von 192 Samples pro Sensor führt.

Annotationen

Für jedes dieser Samples (192x2) wurden die Objektinstanzen im linken Kamerabild manuell annotiert (Instanzmaske + Objekt-Klasse). Die Annotationen stehen in Form von 8-bit Graustufenbildern zur Verfügung, welche die semantischen Klassen im Bild darstellen. Da jedes Objekt nur einmal im Bild vorkommt, können aus diesem Format gleichzeitig auch Objektinstanzmasken gewonnen werden.

Das Datenset ist folgendermaßen strukturiert:

STIOS

|--rc_visard

| |--conveyor_belt

| | |--left_rgb

| | |--right_rgb

| | |--gt

| | |--depth

| | |--left_rgb_pattern

| | |--right_rgb_pattern

| | |--depth_pattern

| |--lab_floor

| |-- ...

|--zed

| |-- conveyor_belt

| | |--left_rgb

| | |--right_rgb

| | |--gt

| | |--depth

| | |--normals

| | |--pcd

| |--lab_floor

| |--...

Es stehen außerdem Code-Utilities zur Verfügung, die die Visualisierung von STIOS ermöglichen und Funktionen beinhalten, um beispielsweise Bounding-Box-Annotationen aus den semantischen Graustufenbildern zu generieren.

Referenzliteratur

Bei Verwendung des Datensets wird gebeten, das Paper Unknown Object Segmentation from Stereo Images zu zitieren, in dem STIOS vorgestellt wird:

@misc{durner2021unknown,

title={Unknown Object Segmentation from Stereo Images},

author={Maximilian Durner and Wout Boerdijk and Martin Sundermeyer and Werner Friedl and Zoltan-Csaba Marton and Rudolph Triebel},

year={2021},

eprint={2103.06796},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

STIOS in Projekten

Unknown Object Segmentation from Stereo Images

M. Durner, W. Boerdijk, M. Sundermeyer, W. Friedl, Z.-C. Marton, and R. Triebel. Unknown Object Segmentation from Stereo Images. In: 2021 IEEE/RSJ International Conference on Intelligent Robots and Systems, IROS 2021. International Conference on Intelligent Robots and Systems, 27 Sep - 1 Oct, Prague. ISBN 978-166541714-3. ISSN 2153-0858.

Diese Methode ermöglicht das Segmentieren von unbekannten Object-Instanzen, welche sich auf horizontalen Oberflächen (z.B. Tischen, Böden etc.) befinden. Aufgrund der in robotischen Anwendungen oftmals unvollständigen Tiefendaten werden hier Stereo-RGB-Bilder verwendet. STIOS wird dabei verwendet, um zum einen die Funktionalität von Stereo-Bildern für unbekannte Instanz-Segmentierung zu zeigen, und zum anderen einen Vergleich mit vorhandenen Arbeiten zu ziehen, welche zum Großteil direkt auf Tiefendaten zurückgreifen.

"What's This?" - Learning to Segment Unknown Objects from Manipulation Sequences

W. Boerdijk, M. Sundermeyer, M. Durner, and R. Triebel. 'What's This?' - Learning to Segment Unknown Objects from Manipulation Sequences. In: 2021 IEEE International Conference on Robotics and Automation, ICRA 2021. IEEE Robotics and Automation Society. 2021 IEEE International Conference on Robotics and Automation, ICRA 2021, 31 May - 05 June 2021, Xi'an, China / online (hybrid). ISBN 978-172819077-8. ISSN 1050-4729.

Diese Arbeit befasst sich mit der Segmentierung von Objekten, die von einem Roboterarm gegriffen wurden. Mit Hilfe dieser Methode ist es möglich, in einem automatisierten Verfahren objekt-spezifische Bilddaten zu erzeugen. Diese Daten können im Anschluss für das Trainieren von Objektdetektoren oder Segmentierungsansätze verwendet werden. Um die Verwendbarkeit der generierten Daten zu zeigen, wird in dieser Arbeit STIOS als Evaluierungsdatensatz für Instanzsegmentierung auf RGB-Bildern verwendet.

Ähnliche Datensätze

Es existieren einige ähnliche Datensätze von Objekten auf Tisch-ähnlichen Oberflächen mit verschiedenen Annotationen:

- OCID zeigt 89 Objekte, die mit zwei verschiedenen Sensoren in unterschiedlichen Zusammenstellungen aufgenommen wurden (z.B. klar voneinander getrennt, gestapelt, ...).

- M. Suchi, T. Patten, D. Fischinger, and M. Vincze (2019). EasyLabel: a semi-automatic pixel-wise object annotation tool for creating robotic RGB-D datasets, International Conference on Robotics and Automation (ICRA), 2021.

- OSD besteht aus ähnlichen physischen Objektarrangements für zylindrische und quaderförmige Objekte.

- A. Richtsfeld, T. Mörwald, J. Prankl, M. Zillich, and M. Vincze. Segmentation of unknown objects in indoor environments, International Conference on Intelligent Robots and Systems (IROS), 2012.

- TUW zeigt komplexe, verschachtelte Objektkonfigurationen.

- A. Aldoma, T. Fäulhammer and M. Vincze. Automation of 'ground truth' annotation for multi-view RGB-D object instance recognition dataset, International Conference on Intelligent Robots and Systems (IROS), 2014.

- Einige Datensätze sind auf Objekterkennung fokussiert und liefern Annotationen in Form von Bounding Boxen und Objektposen oder auch Punktwolken.

- Z. Sui, Z. Ye, and O. C. Jenkins. Never Mind the Bounding Boxes, Here's the SAND Filters, arXiv preprint arXiv:1808.04969 (2018).

- C. Rennie, R. Shome, K. E. Bekris, and A. F. De Souza. A dataset for improved rgbd-based object detection and pose estimation for warehouse pick-and-place, Robotics and Automation Letters (RA-L), 2016.

- A. Ecins, C. Fermüller, and Y. Aloimonos. Cluttered scene segmentation using the symmetry constraint, International Conference on Robotics and Automation (ICRA), 2016.